11.1 Matriz de Confusión

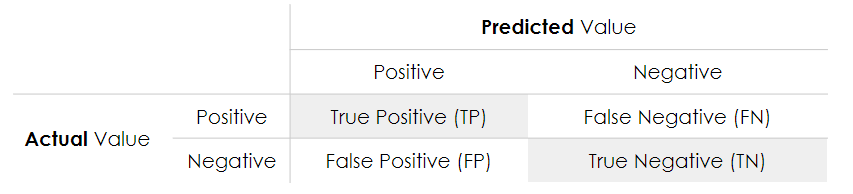

La confusion matrix o matriz de confusión muestra el número de predicciones correctas e incorrectas hechas por el modelo en comparación con los resultados reales en los datos. La matriz de confusión es una matriz \(n \times n\), donde \(n\) es el número de clases.

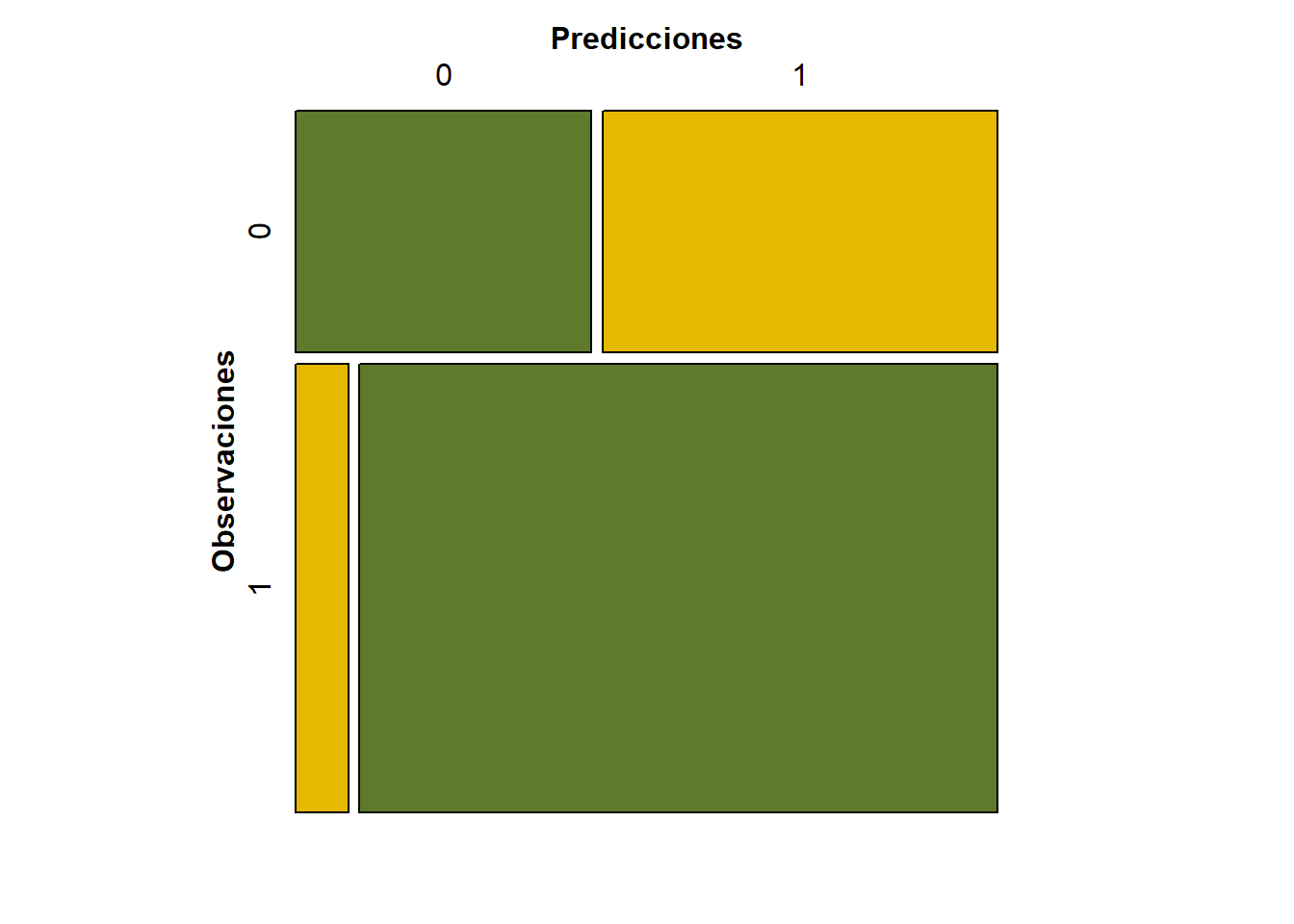

En el ejemplo de Venta de Vehículos tenemos la siguiente matriz de confusión:

- Precisión (Accuracy): la proporción del número total de predicciones correctas.

\[ACC = \frac{TP+TN}{TP+TN+FP+FN}\]

- Verdaderos Positivos (Positive Predictive Value): la proporción de casos positivos que fueron identificados correctamente.

\[PPV = \frac{TP}{TP+FP}\]

- Verdaderos Negativos (Negative Predictive Value): la proporción de casos negativos que fueron identificados correctamente.

\[ NPV = \frac{TN}{TN+FN} \]

- Sensibilidad (Sensitivity or Recall): la proporción de casos positivos reales que están correctamente identificados.

\[TPR = \frac{TP}{TP+FN}\]

- Especificidad (Specificity): la proporción de casos negativos reales que están correctamente identificados.

\[TNR = \frac{TN}{TN+FP}\]

## Confusion Matrix and Statistics

##

## Reference

## Prediction No Yes

## No 15 20

## Yes 5 60

##

## Accuracy : 0.75

## 95% CI : (0.6534, 0.8312)

## No Information Rate : 0.8

## P-Value [Acc > NIR] : 0.91252

##

## Kappa : 0.3902

##

## Mcnemar's Test P-Value : 0.00511

##

## Sensitivity : 0.7500

## Specificity : 0.7500

## Pos Pred Value : 0.9231

## Neg Pred Value : 0.4286

## Prevalence : 0.8000

## Detection Rate : 0.6000

## Detection Prevalence : 0.6500

## Balanced Accuracy : 0.7500

##

## 'Positive' Class : Yes

##